Forschungsprogramm der ersten Bewilligungsphase

Automatismen

Strukturentstehung außerhalb geplanter Prozesse in Informationstechnik, Medien und Kultur

Zusammenfassung

Automatismen sind definiert als Abläufe, die sich einer bewussten Kontrolle weitgehend entziehen. Die Psychologie kennt Automatismen im individuellen Handeln; die Soziologie untersucht Prozesse der Habitualisierung und der Konventionalisierung, Ökonomen haben den Markt als einen Automatismus beschrieben.

Automatismen bringen – quasi im Rücken der Beteiligten – neue Strukturen hervor; dies macht sie interessant als ein Entwicklungsmodell, das in Spannung zur bewussten Gestaltung und zu geplanten Prozessen steht. Automatismen scheinen insbesondere in verteilten Systemen wirksam zu sein; Automatismen sind technische bzw. quasi-technische Abläufe; gleichzeitig stehen sie in Spannung zum Konzept des technischen Automaten.

Das Graduiertenkolleg will Dissertationsprojekte versammeln, die Automatismen im Feld der Medien, der Informationstechnik und der Kultur untersuchen, und zwar materialanalytisch, mit den Mitteln der Theorie oder der ingenieurmäßigen Konstruktion. Das Kolleg ist interdisziplinär angelegt: Auf Seiten der Betreuer/innen sind Kultur- und Sozialwissenschaften, Medienwissenschaften, Literatur- und Filmwissenschaft sowie die Informatik beteiligt; konstitutiv ist der Brückenschlag zwischen Kulturwissenschaft und Informatik. Die Promovend/innen sollen ebenfalls aus den genannten Feldern kommen.

Forschungskonzept

Forschungskonzept

Automatismen im Sinne des Graduiertenkollegs sind, wie Technologien, Praktiken der Formung und Formierung, die in Kategorien der Funktion zu denken sind, wenngleich sie sich nicht auf eine im Voraus berechenbare Rationalität reduzieren lassen. Automatismen sind unhintergehbar und übersteigen den Horizont jeder subjektiven, willentlichen Verfügbarkeit. Sie fügen sich zwar zu einem Regime hochwirksamer ‚Logiken’ zusammen, ihre Wirkungen sind aber (aufgrund der unüberschaubaren Pluralität der beteiligten Kräfte) in gewisser Weise Zufallseffekte. Sie verdanken sich nicht dem Willen eines planvoll handelnden Subjekts, der sich in ihnen manifestiert, sondern sind Bestandteil eines wirkmächtigen Arrangements von Dingen, Zeichen und Subjekten.

Im so skizzierten Rahmen können konkrete Medienphänomene auf neue Weise betrachtet werden. Das Graduiertenkolleg will Dissertationsprojekte versammeln, die Automatismen im Feld der Medien, der Informationstechnik und der Kultur untersuchen. Anknüpfungspunkt sind aktuelle Beobachtungen im Feld der Kultur, mediale und gesellschaftliche Phänomene, zu denen die These des Graduiertenkollegs einen neuen Zugang erlaubt; hier kann die Kulturtheorie etablierte Modelle und Konzepte beisteuern; gleichzeitig ist es das Ziel, technische Lösungen als Erfahrungsbereich, und die theoretischen Konzepte der Informatik als Dialogpartner kulturwissenschaftlicher Ansätze zu nutzen.

Teilbereiche und Projekte

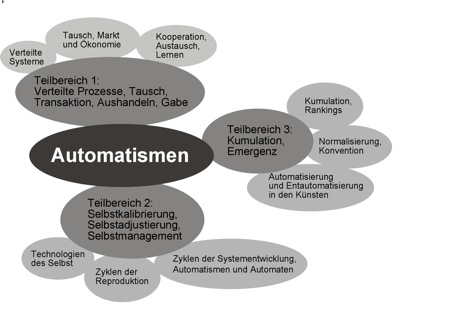

Der Forschungszusammenhang des Graduiertenkollegs orientiert sich an bestimmten erkenntnisleitenden Hypothesen, die im Vorfeld erarbeitet wurden und die, je nach Bedarf und Fragestellung, in den Promotionsprojekten aufgegriffen und weiterentwickelt werden sollen. Sie dienen dazu, das Konzept der Automatismen zu konkretisieren.

1. Verteilter Charakter: Grundhypothese ist, dass Automatismen vor allem dort zum Tragen kommen, wo verschiedene Akteure ohne zentrale Lenkung von einander unabhängig handeln. Innerhalb der Medien scheinen es vor allem die Nutzungsprozesse zu sein, die strukturgenerierend wirken und die ein bottom-up-Ansatz entsprechend berücksichtigen muss. Im Feld der Technik sind es die verteilten Systeme, die hier besonders relevant sind.

2. Die Frage nach dem Selbst: Mit den Automatismen zwangsläufig verbunden – der griechische Wortstamm ‚auto-’ spricht es aus – ist die Frage nach dem Selbst und nach den Bedingungen, die es hervorbringen. Der traditionelle Verweis auf das Subjekt ist irritiert worden durch die subjektkritischen Ansätze der Philosophie; im Feld der Technik durch die Künstliche Intelligenz und die Robotik, und in jüngerer Zeit durch die Techniktheorie etwa Latours, dessen Akteur-Netzwerk-These zwischen menschlichen und technisch-apparativen Aktanten nicht mehr trennt.

In diesem Feld bestehen umfangreiche Vorarbeiten vor allem zur Frage, auf welche Weise Subjektkonstitution und gesellschaftlich-mediale Prozesse sich wechselseitig bedingen. Technologien des Selbst, Selbstmanagement und Selbststilisierung haben an gesellschaftlicher Bedeutung gewonnen und werden in soziologischem wie in medienpädagogischem Rahmen behandelt.

3. Akkumulation / Emergenz: Dritte Grundhypothese ist, dass innerhalb von Automatismen quantitative Prozesse eine Rolle spielen. Neue Strukturen scheinen u. a. durch Prozesse der Kumulation zu entstehen. Die Lastmodelle der Informatik bieten hierfür eine Grundlage; die Kulturwissenschaft kann dies ergänzen z.B. durch Modelle der Gedächtnistheorie und der Konventionalisierung, die die konstitutive Rolle z.B. der Wiederholung betonen.

Die drei genannten Grundhypothesen tragen den Forschungszusammenhang; das Graduiertenkolleg wurde diesen Hypothesen entsprechend in Teilbereiche und Projekte gegliedert. Die Projekte operationalisieren die Fragen des Graduiertenkollegs. Sie sind Teil des Forschungsansatzes und stellen den Rahmen für mögliche Dissertationsprojekte dar:

Der erste Teilbereich folgt der These, dass Automatismen vor allem dort zum Tragen kommen, wo disperse, dezental verteilte Handlungsträger ohne direkte Abhängigkeit voneinander agieren. Wo ein strikter institutioneller Rahmen fehlt, stiften Kommunikationsprozesse, Tausch und Austausch, das Netz, das die Handlungsträger verbindet. Der Teilbereich soll erforschen, wie, wo und wann Kommunikation ‚automatisiert’ in Strukturbildung übergeht.

1.1 Verteilte und mobile Systeme

Ein besonderer Denkanreiz für das Graduiertenkolleg sind ‚verteilte Systeme’, mit denen die Informatik sich in zunehmendem Maß beschäftigt. Zwei Mitglieder des Kollegs (Meyer auf der Heide und Karl) arbeiten speziell in diesem Bereich. Von den Netzen der Mobilfunks über so genannte ad hoc Netze bis hin zu Waren, die mittels RFID-Etiketten ‚spontan’ miteinander kommunizieren – die Entwickler verteilter Systeme sehen sich besonderen Anforderungen gegenübergestellt. So sind diese mit ihrem Nutzungsprozess auf völlig neue Weise verwoben; die Strukturmuster, die entstehen, entstehen weitgehend ungeplant, als Automatismen; die Entwickler finden sich in einer neuen Position der Beobachtung wieder.

Ziel des Projekts ist es, verteilte Systeme analog zu sozialen Systemen neu zu beschreiben. Es sollen Modelle entwickelt werden, wie unter einem verallgemeinerten Informationstransaktionsbegriff die Ausbreitung von Information in informellen Netzen geschieht. Dabei sind (u. a.) ein verallgemeinertes Kostenmodell und ein Genauigkeitsmaß zu erarbeiten.

Methode: Aufarbeitung sozial- und kulturwissenschaftlicher Modelle zur Weitergabe von Information zwischen dezentralen Einheiten, Unterschiede zwischen spontanem und zentralisiertem Informationsaustausch, Theorien zum Gerücht, Zusammenhang zwischen Glaubwürdigkeit und Weitergabewahrscheinlichkeit; Entwicklung eines parametrisierten mathematischen Lastmodells.

Stand der Forschung: Das Gebiet der verteilten Systeme ist eines der zentralen Gebiete der Informatik, so dass die Forschung viele verschiedene Facetten aufweist. Klassische Themen wie Vernetzung und Konzeption und Entwurf von kooperierenden Anwendungen (Coulouris 2001) werden in algorithmischer, struktureller und technischer Sicht erweitert. Algorithmen unter anderem für Onlinebearbeitung (Borodin 1998), für Datenmanagement in verteilten Umgebungen (Di Stefano 2005, Bienkowski / Meyer auf der Heide 2005) oder für Ad hoc Kommunikation (Ilyas 2002) berücksichtigen die spezifischen Anforderungen der räumlich und zeitlich verteilten Aktivitäten. In struktureller Hinsicht stellt der Übergang von Client/Server zu Peer-to-Peer basierten Architekturen einen Paradigmenwechsel dar, der zu neuartigen Anforderungen geführt hat (Balakrishnan 2003). Analog dazu erweitern technische Neuerungen wie etwa die drahtlose Kommunikation das Einsatzgebiet verteilter Systeme: die ursprüngliche Mensch-Maschine-Kommunikation wird zunehmend durch eine Maschinen-Maschinen Kommunikation ersetzt. Ein aktuelles Beispiel sind Sensornetzwerke, welche weit reichende Überwachungsaufgaben wahrnehmen (Karl/Willig 2005).

Betreuung: Becker, Karl, Meyer auf der Heide, Wehner.

Querbezüge zu 1.3, 3.1, 3.2.

1.2 Tausch, Markt und Ökonomie

Ein Beispielraum, der sich für die Fragestellung des Graduiertenkollegs in besonderer Weise anbietet, sind Markt und Ökonomie; Automatismen und ,spontane’ Strukturentstehung werden – gerade in der Öffentlichkeit – häufig am Beispiel der Ökonomie diskutiert: Die ‚invisible hand’ des Marktes ist an die Stelle der ‚visible hand’ planender Gestaltung getreten. Dies zeigt sich nicht nur in mit ethnographischen Methoden arbeitenden Feldstudien, in denen z.B. die Entstehung und „Verfestigung“ von Kooperation untersucht wird (vgl. ursprünglich Malinowski 1922), sondern auch in zahlreichen, von experimentell arbeitenden Ökonomen durchgeführten Laboruntersuchungen (vgl. Bowles und Gintis 2002 sowie Fehr und Gächter 2002). Obgleich die Ergebnisse vordergründig den Schluss nahe zu legen scheinen, dass der „homo oeconomicus“ bestenfalls eine karikierende Beschreibung menschlichen Verhaltens darstellt, zeigt sich bei genauerem Hinsehen, dass die in diesem Kontext zentrale Annahme der neoklassischen Theorie − die individuellen Akteure sind rationale Nutzenmaximierer, für die stets die Partizipations- und die Anreizkompatibilitätsbedingung erfüllt sein muss, damit sie überhaupt aktiv werden − durchaus mit der Vorstellung spontanen „(pro-)sozialen“ Verhaltens kompatibel ist.

In das Graduiertenkolleg kann hier ein Forschungsprojekt eingebracht werden, das Ähnlichkeiten zwischen ökonomischem Tausch und dem symbolischen Austausch der Medien untersucht (Winkler 2004.01, 2005.21). Als zweites besteht ein umfangreicher Forschungszusammenhang zum Thema der Gabe (Ecker). Dieser Ansatz ist besonders interessant, weil er die Ökonomie von ihrer Grenze her reflektiert und damit geeignet scheint, das Modellhafte der Ökonomie selbst zu befragen. Prof. Frick bringt wirtschaftswissenschaftliche Kompetenz in das Teilprojekt ein.

Ziel des Projekts ist es, kultur- und sozialwissenschaftliche Arbeiten zu Tausch, Austausch und Gabe unter dem thematischen Aspekt des Kollegs neu zu betrachten. Gibt es Unterschiede zwischen dem Warentausch und dem symbolischen Tausch? Gibt es Automatismen, die in beiden Bereichen gelten? Handelt es sich beim Markt um ein ‚verteiltes System’? Und ebenso im Falle der Medien? Können Beziehungen zu den technischen Systemen hergestellt werden, wie sie das Teilprojekt 1.1 behandelt?

Methode:Aufarbeitung kulturtheoretischer Verwendungen ökonomischer Modelle.

Stand der Forschung: Zur Relevanz ökonomischer Modelle innerhalb der Medienwissenschaft: Innis (1950/97), Mattelart (1994/96); historische Schnittstellen zwischen Nationalökonomie/Volkswirtschaftslehre und Medientheorie: Spreen (1998), Vogl (2002), Balke (1996, 2004); zum Übergang zwischen Ökonomie und Semiotik: Goux (1973/90), Rossi-Landi (1965/83); ‚Aushandeln’ von Bedeutung: Greenblatt (1988). Ökonomische Modelle innerhalb der Psychoanalyse: Freud (1915/75), Heim (1986), Ökonomien des Begehrens: Lyotard (1974/84), Žižek (2001).

Zur Theoriedebatte über die Gabe als Sonderform des Ökonomischen, Modell der An-Ökonomie: Mauss (1924), Malinowski (1979), Strathern (1988) in der Ethnologie; Starobinski (1994) in der Kulturgeschichte; Bataille (1949), Derrida (1993), Bourdieu, Godelier (1999) in Philosophie und Psychoanalyse; Il dono (2001) in der Kunstgeschichte; Haselstein (2000), Vogl (2002), Blaschke (2004) in der Literaturgeschichte.

Betreuung: Ecker, Frick, Winkler.

Querbezüge: 1.1, 1.3, 2.1, 3.1, 3.2.

1.3 Kooperation, Austausch, Lernen

Das dritte Projekt fragt nach Automatismen auf der Ebene von Gruppenprozessen. Verteilte Systeme spielen zunehmend dort eine wichtige Rolle, wo einander unbekannte Akteure Kontakt aufnehmen und gemeinsame, auf einen bestimmten Zweck hin ausgerichtete Aktivitäten planen und koordinieren. Beispiele hierfür reichen von der Freizeitgestaltung (Events) über politische Aktivitäten und spontane Protestaktionen bis hinein in Bereiche des vernetzten Lernens und Arbeitens (Wikipedia, virtuelle Wissensräume, Wissensnetzwerke; Virtuelle Unternehmen). In den genannten Beispielen formieren sich zuvor oft unverbundene und einander unbekannte Einzelakteure zu Kollektivgebilden, deren befristeter Zusammenhalt sich wesentlich dem Einsatz spezieller Medien verdankt: Mobilfunk, Webschnittstellen, virtuelle Begegnungsstätten oder Agentensysteme sind hier zu nennen. Medien übernehmen u. a. die Funktion des Monitorings und der Analyse; ein Beziehungsgeflecht, das automatisiert entsteht und für die Beteiligten möglicherweise opak bliebe, wird mit technischen Mitteln beobachtbar gemacht.

Ziel ist es, anhand von empirischen Fallstudien die Strukturmerkmale dieses relativ neuen Typs medialer Mobilisierung und Koordination herauszuarbeiten (Spontanität, Verzicht auf übergeordnete Planung, relative Unverbundenheit und Heterogenität der Beteiligten, weiche Bindungen, Internet als Ausdrucks- und Organisationsmedium). Die Ergebnisse dieser Untersuchungen sind in Verbindung zu setzen zu relevanten bekannten gesellschaftlichen und technologischen Vorläufer- und Parallelentwicklungen (z.B. Individualisierung, Projektförmigkeit unternehmerischer Aktivitäten, Themenorientierung politischen Engagements, kollaboratives Lernen, sog. ‚mobile’ und ‚nomadic computing’); weiter ist eine Einbettung in Theoriekontexte (u. a. Netzwerktheorie) zu leisten.

Drei der beteiligten Forscher arbeiten in diesem Bereich: Keil über kooperative Medien und virtuelle Wissensräume; Meister über neue Formen des computerunterstützten Lernens und Arbeitens (Meister 2004, 2004a), und Wehner über elektronische Vernetzungen im politischen und wirtschaftlichen Umfeld (Wehner 2002.2; 2001.21; 2001.22; 2001.23).

Methode: Empirische Studien zu den Fallbeispielen mittels qualitativer und quantitativer Befragung von ‚usern’, Logfile-Analysen; Theoriearbeit. Mit ‚sTeam’ liegt eine Software-Plattform vor, die in Paderborn entwickelt wurde und die für Fallstudien in diesem Feld eingesetzt werden kann.

Stand der Forschung: Rheingold (2002) liefert mit Beobachtungen spontaner Vernetzungen (‚social swarming’) wichtige empirische Anhaltspunkte, während Castells (2003) große Studie zur Netzwerkgesellschaft eine gesellschaftstheoretische Rahmung bietet. Ebenso wichtig sind Studien, die die Bedingungen von Teilsystemen reflektieren; Beispiele sind hier Willkes Ausführungen zum kollektiven Wissensmanagement in der modernen Wissensökonomie (2002), die Arbeiten von Andriessen (2003) und Issing/Klimsa (2001) zu Formen des kooperativen und kollaborativen Lernens, die Analysen von Eigner (2003), Möller (2005) und Weinberger (2002) zu neuen Kommunikationsformen im Internet, die Beiträge in Wellman (1999) und Wellman/Haythornthwaite (2001) zur Relevanz des Internet für die Gründung und Aufrechterhaltung persönlicher Netzwerke, politikwissenschaftliche Arbeiten wie die von Putnam zum Geltungsverlust von Parteien und Verbänden für die Mobilisierung gesellschaftlichen Engagements und schließlich Prognosen zur Computerentwicklung wie die von Weiser (1999).

Betreuung: Keil, Meister, Wehner. Querbezüge: 2.1, 2.2, 2.3, 3.3.

Automatismen setzen ein ‚Selbst’ einerseits voraus: andererseits ist zu fragen, wie ein ‚Selbst’ entsteht, wie es sich stabilisiert und reproduziert, und welchen Anteil hieran wiederum Automatismen haben. Gesellschaftlich ist zu beobachten, dass Mechanismen der Selbstkonstitution zunehmende Aufmerksamkeit zukommt: Im Zurücktreten traditionaler Bindungen und der Flexibilisierung von Rollenvorgaben werden Selbstkonstitution und Selbstmanagement zunehmend verlangt, dies wird von den Betroffenen als zunehmend belastend erfahren. Selbstkonstitution erscheint als auferlegt – in deutlicher Spannung zu den Konnotationen einer positiv besetzten Autonomie, die der Begriff ebenfalls mit sich führt.

Auf Seiten der Technik kann das Konzept der Automatismen abgegrenzt werden über die Theorien zum Automaten. Hier ist es die Vorstellung einer mechanischen Selbsttätigkeit, die den Begriff bestimmt.

2.1 Technologien des Selbst

Innerhalb der Sozialwissenschaften wird betont, dass Selbstkonstitution sich immer in einem Wechselverhältnis vollzieht – im Wechselverhältnis zwischen Subjekt und Gesellschaft, und zweitens im Wechselverhältnis zwischen Subjekt/Gesellschaft und Technologie.

Soziale Prozesse der Technisierung und Automatisierung ergreifen immer auch den Menschen selbst. Der Begriff der ‚Automatismen’ dient auf dieser Ebene zur Beschreibung disparater Vorgänge, die zwar, wie körperliche und psychische Haltungen, automatisch, nämlich unbewusst funktionieren und von daher gleichsam als ‚technisch’ zu beschreiben sind, aber rein technische Funktionsabläufe überschreiten.

Widerlager dieser Frage ist der Begriff des (technischen) Automaten. Kann technischen Anordnungen ein ‚Selbst’ zugestanden werden? Welcher Grad von Autonomie ist hierfür gefordert? Und wenn sich das Selbst der Subjekte in der Wechselbeziehung zu gesellschaftlich/technischen Anordnungen entwickelt – entwickelt sich auch die Technologie in zyklischen Prozessen, im Durchgang durch Gesellschaft, Alltag, Gebrauch und Massenkultur?

Ziel des Projektes ist es zu untersuchen, wie sich Mechanismen der Selbstkonstitution im Wechselspiel zwischen Subjekt, Gesellschaft/Massenkultur und Technologie vollziehen und wie sie sich historisch verändert haben. Hierzu bestehen umfangreiche Vorarbeiten vor allem bei den beteiligten Sozialwissenschaftlern; Publikationen und Fachtagungen liegen vor zu: Identitätsfragen im Internet, Automatentheorien und Robotik (Becker), zu Subjekttechnologien und zur strukturbildenden Funktion medien- und soziotechnischer Anordnungen in der Massenkultur (Bublitz).

Methode: Sozialwissenschaftliche Theoriearbeit.

Stand der Forschung: Neuere Forschungsarbeiten zur Subjekt- und Selbstkonstitution bewegen sich im Spektrum poststrukturalistischer Subjektkritik. Hier sind vor allem die – macht- und subjekttheoretischen – Arbeiten von Bourdieu, Butler, Foucault und Derrida zu nennen (vgl. Bourdieu 1979, 1989, 1990; Bourdieu/Wacquant 1996; Butler 1991, 1995, 2001 und 2003; Foucault 1977, 1986, 1987, 1993, 2000; und Derrida 1972/1997, 1974/1996; vgl. zur Überschreitung des Subjektparadigmas auch Habermas 1986). Die Annahme, dass die Freisetzung selbstregulativer Mechanismen ein wesentliches Element moderner Subjektivierung bildet, rekurriert darüber hinaus auf Analysen zum Zusammenhang von Individualisierungsprozessen und Selbstorganisation in der reflexiven Moderne (Beck 1984; 1996; Beck/Bonß 2001). Dabei geht es um Selbsttechnologien in einem umfassenden Sinne: Angesprochen sind damit sowohl kulturelle Muster der Selbstkonstitution, Prozesse der Selbststeuerung und Praktiken der Selbstführung wie auch Formen der – exzessiven − Selbstthematisierung, der Selbstbeobachtung und des Selbstmanagements. Aktuelle Diskurse zur Selbstkonstituierung spätmoderner Subjekte legen den Schluss nahe, dass es in technisch-medial organisierten und neoliberal verfassten Gesellschaften zu neuen Formen der Selbstinszenierung kommt, die auf eine veränderte Praxis der Selbstkonstitution hinweisen (Bauman 1997, 1999, 2000, 2003; Bröckling 2000; Lemke et al. 2000; vgl. zur performativen Produktion des Subjekts in − ritualisierten − Formen der öffentlichen Selbstinszenierung, auch in medialen Kontexten Bublitz 2005, 2006; Butler 2003; Balke/Schwering/Stäheli 2000; Tholen 2001).

Betreuer: Becker, Bublitz, Meister, Sutter.

Querbezüge zu 1.3, 3.2 und 3.3.

2.2 Zyklen der Reproduktion, Systementstehung, Systemerhalt

Die Überlegungen zur Selbstkonstitution unterstellten bereits, dass sich Prozesse der Selbststeuerung in zyklischen Rückkoppelungsschleifen vollziehen. Zyklen der Reproduktion spielen eine Rolle in der Biologie und der Evolutionslehre und sind von dort aus in die Kybernetik übernommen worden; Basisvorstellungen wie Rückkopplung und Regelkreis gehen auf die Erfahrung technischer Apparaturen zurück; das Selbst- der Selbstkonstitution und das Auto- der Automatismen enthält die Zyklen als reflexives Moment.

Die Systemtheorie generalisiert das Modell im Konzept der Autopoiesis bzw. der Emergenz. Systementstehung und Systemerhalt werden hier in systematischer Weise beschrieben. Grundlegendes Konzept hierbei bildet der operative Konstruktivismus, der von der selbstreferenziellen Bildung (Selbstkonstitution) und Abgrenzung von Systemen ausgeht: Systeme werden nicht produziert, sondern entstehen in den laufenden rekursiven Anschlüssen systeminterner Operationen. In diesem Rahmen untersucht die Systemtheorie die medienbedingte Formung rekursiv aneinander anschließender Kommunikationen sowie die Funktionen von Kommunikationsmedien in zunehmend komplexen Gesellschaften (Erfolg und Verbreitung von Kommunikation, Gedächtnis-, Speicher- und Thematisierungsfunktion).

Im Rahmen des Graduiertenkollegs kann dies nur als Hintergrund fungieren; im Feld der Medienwissenschaft allerdings erscheint die Frage konkret operationalisierbar, denn hier wurden vergleichbare Zyklen ausführlich untersucht, und zwar am Beispiel oraler Kulturen, deren Traditionsbildung auf dem Ritus, auf Zyklizität und Wiederholung beruht. Serialität spielt innerhalb der Medien eine große Rolle; der für die Medienwissenschaft zentrale Begriff der ‚technischen Reproduktion’ und das Informatik-Konzept iterativer bzw. rekursiver Funktionen kann hier einen wichtigen Schlüssel bilden. In der sozialwissenschaftlichen Medienforschung kann die zyklische Etablierung und Reproduktion medialer Formate und Attraktoren (wie Nachrichtenwertfaktoren) als Prozess rekursiver Eigenwertbildung untersucht werden.

Ziel des Projekts ist es zu zeigen, wie zyklische Reproduktionsprozesse in Automatismen münden.

Methode: zunächst wären die theoretischen Grundlagen aufzuarbeiten (Zusammenhänge zwischen gesellschaftlicher Ausdifferenzierung und Medienevolution, Theorien zu Speicher und Gedächtnis, Wiederholung und Reproduktion, Performativitätstheorien, zyklische Modelle der Kybernetik); zweitens wären medienhistorische Darstellungen unter dem skizzierten Aspekt durchzusehen, um die Frage an ausgewählten historischen Zeitschnitten zu konkretisieren; drittens wären aus dieser Sicht aktuelle Analysen von Formen und Funktionen der Medien in der Gesellschaft aufzuarbeiten und zu erstellen.

Stand der Forschung: Zum gegenwärtigen Stand der Kybernetik-Debatte: Pias (2003/04), und dort insbesondere Pias (2004_2) und (Coy 2004), historisch: Wiener (1952, 1963) sowie Vogl (2004); zum Begriff der Reproduktion Bergermann (2002, 2002_2); zum Konzept der Autopoiesis: Luhmann (1984/93 60ff., 1997 65ff.), sowie Guwang (2000); zur gesellschaftlichen Ausdifferenzierung und Medienevolution: Luhmann 1997 249ff., Merten (1994); zur Systemtheorie der Medien: Luhmann (1997 190ff.), Sutter (2001), Wehner (2000); Zur Oralität und der konstitutiven Rolle der Wiederholung: Ong (1982/87), Assmann (1988, 1991); Serialität in den Medien: Giesenfeld (1994), Bippus (2000); Zur Performativität wird gegenwärtig eine verzweigte Debatte geführt; beispielhaft: Fischer-Lichte (1998, 2001), Krämer (2004), Winkler (2004.23). Zu Formen und Funktionen der Medien in der modernen Gesellschaft: Göbel (2006), Luhmann (1996), Wehner (1997).

Betreuung: Adelmann, Eke, Sutter, Winkler.

Querbezüge ergeben sich insbesondere zu 2.1, 2.3, 3.1, 3.3.

2.3 Zyklen der Systementwicklung, Automatismen und Automaten

Sehr konkret stellt sich die Frage nach den Zyklen der Reproduktion für die Entwickler technischer Systeme. Softwarepakete etwa werden nach einem vereinbarten Stufenplan erstellt, und dann an den Nutzer übergeben; in der Praxis, im Gebrauch bewähren sie sich oder bewähren sich nicht, die Kritik der Nutzer wird die Nachbesserung, und damit den nächsten Entwicklungszyklus einleiten.

Dieses klassische Entwicklungsmodell setzt voraus, dass der Entwickler ein konkretes Gegenüber hat, das die Kritik (Brauchbarkeit oder Unbrauchbarkeit) kommuniziert; dies ist insbesondere bei verteilten Systemen nicht der Fall. Zudem erscheint nicht immer sichergestellt, dass das explizite Urteil, wie es etwa die Marktforschung empirisch ermittelt, die tatsächliche Nutzerzufriedenheit/-unzufriedenheit zutreffend spiegelt. Die Informatik reagiert, indem sie neue Wege der Systementwicklung sucht, die dialogischer, in enger Abstimmung mit dem Nutzungsprozess vorgehen. Hierzu gibt es Vorarbeiten (Keil-Slawik 1992.11, 2000.26).

Ziel ist zum einen die Beobachtung konkreter Entwicklungsprozesse unter dem Aspekt des ‚Durchgangs’ durch den Nutzungsprozess. Ein zweiter Ansatz könnte ein Entwicklungsmodell erarbeiten, das aktuelle und erwartete technische Kenn-daten mit möglichen gesellschaftlichen Trends kombiniert und somit mögliche Erweiterungs- oder Veränderungsszenarien aufzeigt.

Zum dritten wäre die Frage nach Automaten und Automatismen aus der beschrie-benen Perspektive aufzugreifen: während der Entwicklungsprozess selbst geplant ist, beginnt der ‚Automatismus’ sobald die Technologie die Labore verlässt. So kann die Nutzung eigene ‚Automatismen’ entwickeln, die jede in der Technik niedergelegte Intention übersteigen.

Methode: Material wären hier Fallstudien aus dem Fundus der Technikgeschichte, die im Licht der Fragestellung des Kollegs möglicherweise neu zu fassen wären, sowie Kategorien der aktuelleren Techniktheorie; Vorarbeiten zum ‚Missbrauch’ der Fernbedienung im Zapping (Winkler 1991), im praktischen Gebrauch die Bedeutung von Bildschirmtext und SMS, die nicht als primäre Medienfunktionen konzipiert waren (Austastlücke bei der Fernsehbildübertragung bzw. SMS als ‚Abfallprodukt’ des GSM-Standards), sondern unter Ausnutzung anderer Features der jeweiligen Technologie eigene Gebrauchsdimensionen entfalteten (Ulrich 2003), sowie zur Verschränkung von Technik und Gesellschaftstheorie (Becker, Keil-Slawik 2001.27) liegen vor.

Stand der Forschung: Erste Arbeiten zu diesen Themen konzentrierten sich auf Systementwicklungsmethoden und das politisch-institutionelle Umfeld der Systementwicklung (Nygaard/Handlykken 1981, Nygaard 1986), die im skandinavischen Raum zunehmend Einfluss auf Gestaltungsmethoden und Designtheorien entfalteten (zusammengefasst und erweitert in Ehn 1988, Andersen et al. 1990, Dahlbohm/Mathiassen 1993). Zum Teil anschließend an diese frühen Arbeiten entstand eine Serie von stärker empirisch fundierten Untersuchungen zur Praxis des Programmierens (Naur 1992) und zur Anpassung und Entwicklung geeigneter Projektmodelle (Floyd 1981). Mit der breiten Akzeptanz von Prototyping (Floyd 1984) und spiral- oder v-förmigen Projektmodellen (Boehm 1986) verbreiterte sich die Analyse auf anwendungsbezogene Aspekte wie z.B. die Rolle von Fehlern, die Nutzung von Sprachen/Fachsprachen und die selbstorganisierte Ausprägung von Handlungsmustern (Keil-Slawik 1992.11). Weitere Arbeiten behandeln den Einfluss sozialer Faktoren auf die Softwarequalität (Pasch 1994) und allgemeiner die Praktiken von Software-Entwicklern (Degele 1997) sowie Fragen der Wissenssoziologie (Funken 2001) und der Entwicklung offener und kooperativer Technikgestaltungsprozesse (Dierkes 2000). In Bezug auf die Umfeldanalyse treten verstärkt auch Gebrauchsaspekte in den Vordergrund. Ausgangspunkt sind hier Arbeiten von amerikanischen Anthropologen zur Alltagskognition (Rogoff/Lave, 1984, Lave 1988), die später über den Begriff des situierten Handelns mit Artefakten erweitert wurden, um frühzeitig Nutzungsmuster zu identifizieren (Suchman 1987). Mit dem Stichwort ‚Designing for unanticipated Use…’ führte Robinson (1993) vier Dimensionen ein, die die Ausprägung unkonventionellen Benutzungsverhaltens charakterisieren sollten und die letztlich auf die Gestaltung von Artefakten zurückgeführt werden können (Prinz/Mark/Pankoke-Babatz 1998, Pekkola 2003). Ein weiterer Ansatz nutzt das Konzept der Behaviour Settings (Barker 1968), um das Zusammenspiel von Handlungsplänen und Kontextbedingungen zu durchleuchten. Einfließen sollen solche Erkenntnisse in die Kontextmodellierung zur Ausgestaltung von Awareness-Komponenten in CSCW-Systemen (Pankoke-Babatz 2003, Pankoke-Babatz/ Prinz/Schäfer 2004). Einen anderen Ansatz verfolgt Bleek (2004), der für die Entwicklung und Gestaltung von Infrastrukturen das Konzept der Arena einführt und einen Ansatz zur Integration paralleler asynchroner Entwicklungsprozesse vertritt. Ein interessanter Ansatz zwischen diesen Entwicklungslinien stellt das Konzept des ‚Extreme Programming’ dar, das auf Kent Beck und Ward Cunningham zurückgeführt werden kann (Beck 1999 und 2000). Solche Entwicklungsansätze werden meist unter dem Oberbegriff „Agile Softwareentwicklung“ zusammengefasst. Allerdings liegen hier bislang eher programmatische als empirisch fundierte Veröffentlichungen vor, die noch keine anschlussfähigen Konzepte für die Problematik der Ausbildung von Automatismen anbieten.

Betreuung: Karl, Keil, Becker (eine Kooperation mit Prof. Engels und Prof. Schäfer (Softwaretechnik) ist vereinbart).

Querbezüge: 1.1, 1.3.

Automatismen im Sinne des Kollegs haben eine quantitative Seite darin, dass Phänomene der Kumulation eine Rolle spielen; Strukturentstehung in verteilten Systemen vollzieht sich häufig additiv. Gleichzeitig aber ist auch diese Seite alles andere als trivial: quantitative Veränderungen können Entwicklungssprünge auslösen, vor denen die Statistik versagen muss; Phänomene der Verdichtung scheinen ebenso typisch wie diejenigen schlichter Aufhäufung zu sein. Zudem ist zu beobachten, dass die Prozesse der Kumulation sich wiederum in Zyklen vollziehen; Rückkopplung, Resonanz und Selbstverstärkung sind in diesen Zyklen wirksam.

Verschiedene Fachgebiete nutzen den Begriff der Emergenz, um Phänomene der Strukturbildung und den Umschlag von Quantität in Qualität zu beschreiben. Hauptsächliches Kennzeichen emergenter Prozesse ist, dass sie Unerwartetes, Neues hervorbringen. Das Kolleg wird den Begriff als ein Rahmenkonzept aufgreifen, seine Konzeptualisierung z.B. in der Systemtheorie mitvollziehen und seine Verwendbarkeit im interdisziplinären Raum prüfen (Stephan 1999, Stephan 2001, Alexander 1920, Morgan 1923, Morgan 1926, Sellars 1922, Broad 1925, Fromm 2004, Holland 1998, Luhmann 1996.2, Luhmann 1997, Sutter 2006). Gleichzeitig wird es darum gehen, das Konzept an den Sachfragen des Kollegs zu konkretisieren.

3.1 Kumulation, Rankings

In diesen Bereich werden zunächst Vorarbeiten eingebracht, die aus dem Habilitationsprojekt eines der beteiligten Nachwuchswissenschaftler stammen. Adelmann untersucht Rankings als eine Form populärkultureller Ordnungssysteme, die ausgehend von den etablierten Hitparaden und Sellerlisten inzwischen weite Teile des Internet und der Medienlandschaft bestimmen. Buchempfehlungen bei Amazon und das CHE-Ranking der Universitäten, Ergebnislisten der Suchmaschinen und personalisierte Werbung aufgrund von Clusterbildungen – alle diese Anwendungen verbindet, dass man verteilte, empirische Prozesse beobachtet, um sie statistisch versammelt in den populären Diskurs wieder einzuspeisen.

Ziel des Projekts ist es, die Funktionsweise und den kulturellen Stellenwert dieser Rankings und kumulativen Ordnungssysteme zu zeigen. Da z.B. die Schriftgeschichte mit ökonomischen Listen beginnt, ist zudem die Vorgeschichte solcher populärkulturellen Ordnungssysteme aufzuarbeiten. Eine Einzelstudie zur Selbstorganisation der Internetnutzer durch Verweisungs- und Bewertungsaktivitäten ist ebenfalls möglich. Die beteiligten Informatiker planen Untersuchungen zum Effekt der Selbstverstärkung, sowie zu emergenten Rankings in verteilten Systemen. Mit Analysen der Rankingstruktur und des Benutzerverhaltens soll eine vorzeitige Konvergenz zu einer homogenen Darstellung (Selbstverstärkungseffekte aus der Ergebnisdarstellung) erkannt und soweit erforderlich begrenzt werden. Die Ergebnisvielfalt wird in weiteren Iterationen weiter eingegrenzt, um den spezifischen Wünschen des Benutzers gerecht zu werden.

Methode: Theoriearbeit, historische Untersuchungen und Fallstudien.

Stand der Forschung: In der kulturwissenschaftlichen Forschungslandschaft werden die populären Ordnungssysteme als soziokulturelle Automatismen noch kaum thematisiert. Die Veröffentlichungen zum Bestseller (Thomsen/Faulstich 1993, Faulstich 1983, 1986, Hendler 2001, Bloom 2002) und zu Hit und Hitlisten (Fairley 1992, Wicke 1996, Haring 2000) liefern konkretes Material. Auch die wenigen theoretischen Überlegungen beschränken sich häufig auf ein spezifisches Feld wie die Suchmaschinen (Ernst/Heidenreich/Holl 2003, Lehmann/Schetsche 2005) oder eine Rezeptionshaltung (Groys 2004; Shuker 2004). In der Informatiklandschaft überwiegen Forschungsarbeiten zur fundierten Erzeugung (Page/Brin 1998, Haveliwala 2002), Präsentation (Hristidis/Papakonstantinou 2004) und Vereinigung (Rasolofo 2002) von Rankings. Ein breiter Überblick über existierende Technologien findet sich beispielsweise in Nohr (2005) und Baeza-Yates/Ribeiro-Neto (1999). Aktuelle Veröffentlichungen berücksichtigen insbesondere die Kopplung von verschiedenen Informationsquellen unter dem Stichwort Information Fusion (Dasarathy 2003).

Betreuung: Adelmann, Bublitz, Karl, Meyer auf der Heide.

Querbezüge: 1.1, 1.2, 2.2, 3.2.

3.2 Normalisierung, Konvention

Ein wichtiger theoretischer Bezug des Kollegs ist der Begriff der Normalisierung, wie er von Jürgen Link in die Diskussion eingebracht worden ist. Der Kern seiner These ist, dass die Subjekte sich in der Beobachtung des gesellschaftlich ‚Normalen’ zunehmend selbst adjustieren (siehe 2.1). Gesellschaftliche Normen werden durch einen ‚flexiblen Normalismus’ abgelöst.

Auch in Links Normalismus geht es um Quantitäten, insofern es Häufigkeiten sind, die das ‚Normale’ formatieren. Die Gauss-Kurve ist eine statistische Funktion und sie markiert den Ort des Umschlags, an dem Quantitäten/Häufungen strukturrelevant werden. Dass Link auf eine implizite, intuitive Orientierung abhebt, verbindet den Normalismus mit der hier verfolgten Frage nach den Automatismen.

In diesem Bereich besteht ein umfangreicher Forschungszusammenhang der beteiligten WissenschaftlerInnen, der sich u. a. durch ein Forschungsprojekt zur Kulturkrise der Moderne und zahlreiche Publikationen ausweist (Bublitz). Zum anderen liegen hier Vorarbeiten aus dem Habilitationsprojekt Adelmann vor.

Ziel: Das Projekt soll diese These im Hinblick auf soziokulturelle Automatismen prüfen und sie, gestützt auf den Zusammenhang des Kollegs, ausbauen. Insbesondere wünschenswert erscheint die Einbindung in ein allgemeines Modell der Schemabildung und Konventionalisierung (3.3).

Methode: Theoriearbeit; Konkretisierung am Beispiel von Rankings und kulturellen Konventionalisierungen wie Genres.

Stand der Forschung: Die Forschung zur modernen Normalitätsproduktion und ihrer statistische Fundierung geht von Canguilhem (1943/1974) und den Arbeiten von Foucault (vgl. Foucault 1993, 1999, 2003) aus. An das Konzept der Normalisierungsgesellschaft (Foucault 1993, 1999; vgl. auch Sohn/Mertens 1999) und das Normalismus-Konzept von Jürgen Link (Link 1997, Link/Loer/Neuendorff 2003) schließen sich eine Reihe von medienwissenschaftlichen Konkretisierungen an, so z. B. zur Visualisierung der statistischen Verdatung in Infografiken (Gerhard/ Link/Schulte-Holtey 2001) oder zum Narrationstyp ‚(nicht) normale Fahrt’ (Gerhard et al. 2003).

Betreuung: Adelmann, Bublitz, Winkler

Querbezüge: 1.2, 2.1, 2.2, 3.1, 3.3.

3.3 Automatisierung und Entautomatisierung in den Künsten

Der letzte Teilbereich nimmt die Tatsache auf, dass die skizzierten Automatismen innerhalb der Kulturwissenschaften durchaus ambivalent und von einigen Ansätzen äußerst kritisch gesehen werden. So haben etwa der Russische Formalismus und der Prager Strukturalismus (Viktor Šklovskij, Jan Mukařovský) programmatisch vertreten, die Kunst habe die Aufgabe, eine Entautomatisierung zu leisten. Sind automatisierte und konventionalisierte Prozesse einerseits entwicklungsmächtig, unvermeidbar und ‚ökonomisch‛, sind sie gleichzeitig von einer gewissen Blindheit bestimmt; der Vorgang der Automatisierung steht geradezu für die Schwelle zwischen bewusst und unbewusst, und Konventionen bilden underlying assumptions, die sich einer bewussten Reflexion und Gestaltung weitgehend entziehen. Hier also geht es darum, die These des Graduiertenkollegs an eine wichtige Grenze zu führen.

In das Blickfeld des Kollegs rückt die Kunst (Literatur, Theater, Film) als performative Praxis im Spannungsfeld zwischen Autogonese (Automatismen) und Heterogenese (Artefactum), zwischen Autopoiesis (Epiphanie) und Poiesis (Gemachtheit). Damit stellt sich die Frage, wie ästhetische Prozesse konzeptualisiert werden, wie diese Konzeptualisierungen in Praktiken der Formung und Formierung eine Übersetzung finden und welche Bedeutung Automatismen in diesem Rahmen zukommt. Performativitäts- und Spielkonzepte (Schechner, Schramm, Fischer-Lichte; Caillois, Iser, Gebauer/ Wulf) bieten den theoretischen Rahmen auf Seiten der Produktionsästhetik, auf Seiten der Rezeption, im Verhältnis von Kunstwerk und Betrachter (Theater-/Kino-Zuschauer, Leser, Hörer) ist ebenfalls mit einer Verschränkung von Automatisierungs- und Entautomatisierungsprozessen zu rechnen.

Eine besondere Rolle spielen Automatismen im Bereich des Kinos. Das filmische Dispositiv steht im Zusammenhang mit der Erforschung psychischer, kinetischer und kybernetische Abläufe und Automatismen (vgl. die Bewegungsstudien Muybridges und Mareys sowie Charcots Hypnosestudien: Helmholtz und andere arbeiteten an Versuchen der Koppelung zwischen Nervensystem und Apparatur). In den Apparatustheorien entspricht der apparativen Anordnung der Maschine der psychische Apparat: Automatismen des Apparats korrespondieren mit Automatismen im Publikum. Formalismus, Strukturalismus und Semiotik prägen in der Filmtheorie deterministische Richtungen; im Konstruktivismus (Bordwell, Thompson) bildet Film ein geschlossenes System, zu dem ein ‚programmierbares’ Publikum gehört.

Aktuelle phänomenologische und wahrnehmungsästhetische (Sobchack), psychoanalytische und dekonstruktivistische Ansätze (Bellour, Marks) formulieren dagegen Positionen der Nicht-Determinierbarkeit des Verhältnisses zwischen ästhetischem Produkt und Zuschauer. Prozesse der Entautomatisierung werden einerseits verortet in Kontingenzen der Wahrnehmungsmodi (räumliche Anordungen) und Äußerungen des Körpers: diese bewegen sich in einem Spannungsfeld und Wechselspiel zwischen Automatismen, unberechenbaren Reaktionen bzw. Affekten (Shaviro, Massumi) und Gedächtnis (Klippel). Eine dritte Komponente unvorhersehbarer Vorgänge der Entautomatisierung sind im filmischen Material, seiner Beschaffenheit und Ästhetik lokalisiert: Körpervorgänge wie z. B. Weinen und Lachen (Marks, Schlüpmann) im Verhältnis zur Materialität des Films und im Austausch mit dem Publikum (Staiger) haben zwei Seiten: Sie sind steuerbar und individuell dennoch unberechenbar. Sie laufen automatisch ab, gleichzeitig produzieren sie Phänomene, die sich dem Apparat, seinen Intentionen und Automatismen wie auch Formen der Codierung entziehen.

Ziel des Projekts ist es, die Spannung zwischen Automatismen und Entautomatisierung in der Literaturtheorie, Theatertheorie, Filmtheorie und Ästhetik aufzuarbeiten und in Automatismen Anteile zu untersuchen, die ‚Autonomie’ entfalten, und sich damit Strukturbildungen widersetzen, sie kontingent und unkontrollierbar unterlaufen.

Methode: Theoretisch fundierte Analysen am jeweils historischen Material.

Stand der Forschung: Formalismus und Strukturalismus: Šklovskij (1925) und Mukařovský (1967); Cultural Studies: u.a. Grossberg (1992); Greenblatt (1993, 1994, 1995). Filmerfahrung und Wahrnehmungstheorien: Marks 2000, 2002, Sobchak 1992, 2000, 2004); ‚visual fascination‛: Shaviro 1993) und der räumlichen Projektion, Kino, Raum: Schlüpmann 1998, 2002: Gedächtnis: Klippel; (Performativität/Theater: Schechner 1966, 1973; Schramm 1996; Balme 1999; Fischer-Lichte 2004); Spiel: Callois 1982, Iser 1991, Gebauer/Wulf 1998)

Betreuung: Brauerhoch, Bublitz, Ecker, Eke.

Querbezüge: 1.1, 1.2, 2.2, 3.1, 3.2.

In dem Dreieck zwischen Automatismen, zyklischer Reproduktion und Strukturgenese entfaltet sich ein Forschungsfeld, das für ein interdisziplinäres Kolleg viel verspricht.

Es ermöglicht, Dissertationsvorhaben aus verschiedenen Fächern einen gemeinsamen Rahmen zu bieten und auch solche Projekte anzuziehen, die inhaltlich unvermutet, innovativ und deshalb besonders förderungswürdig sind; gleichzeitig ist es abgesichert in der Bezugnahme auf innerhalb der beteiligten Wissenschaften stabil etablierte Einzelmodelle.

Die Frage nach den Automatismen, die das Graduiertenkolleg verfolgt, verbindet verschiedene Ebenen: Angestoßen durch konkrete Beobachtungen in einer Vielzahl verschiedener Erfahrungsräume – von den Forderungen nach Selbstmanagement und den Ich-AGs über den Mobilfunk bis hin zu Automatismen und ‚Stereotypie’ in den Medien – beansprucht sie unmittelbare gesellschaftliche Relevanz. Sie schließt an Debatten an, die auch außerhalb der Universität kontrovers geführt werden, und sie will Querverbindungen zeigen, die dieser Debatte notwendig entgehen. Die erzielten Ergebnisse – dies wäre der zweite Anspruch – sollten in die Debatten wieder einfließen können. Auf der anderen Seite steht die Arbeit an den Begriffen und Konzepten selbst. Wenn die Ausgangsthese richtig ist, dass immer mehr der relevanten Strukturen außerhalb bewusster Planung entstehen, dann bedeutet dies auch, dass ein begriffliches Instrumentarium zur Beschreibung solcher Prozesse noch nicht zur Verfügung steht. Hieran zu arbeiten ist Ziel der beteiligten Forscher. Das Graduiertenkolleg bietet die Möglichkeit, im Rahmen einer klaren Institutionalisierung auch Promovenden in diesen Prozess einzubeziehen.